Hinter den Kulissen: Wie KI wirklich deine Kalorien zählt

Die Entwicklung der Lebensmittelerkennung

Noch vor wenigen Jahren galt die präzise Erkennung von Lebensmitteln auf Fotos als nahezu unmöglich. Frühe Systeme setzten auf einfache Computer-Vision-Methoden, die nur eine begrenzte Auswahl an Speisen unter Idealbedingungen erkennen konnten. Bei schlechtem Licht oder mehreren Komponenten auf dem Teller versagten diese Ansätze meist komplett.

Der Durchbruch kam mit der Entwicklung fortschrittlicher multimodaler Large Language Models (LLMs) – KI-Systemen, die auf riesigen Mengen von Text- und Bilddaten trainiert wurden. Diese Modelle „sehen“ dein Essen nicht nur, sie verstehen es im Kontext – fast wie ein menschlicher Ernährungsexperte.

Fun Fact: Moderne Lebensmittelerkennungsmodelle werden mit Millionen von Essensbildern aus aller Welt trainiert. So können sie Gerichte aus unterschiedlichsten Kulturen und Küchen erkennen.

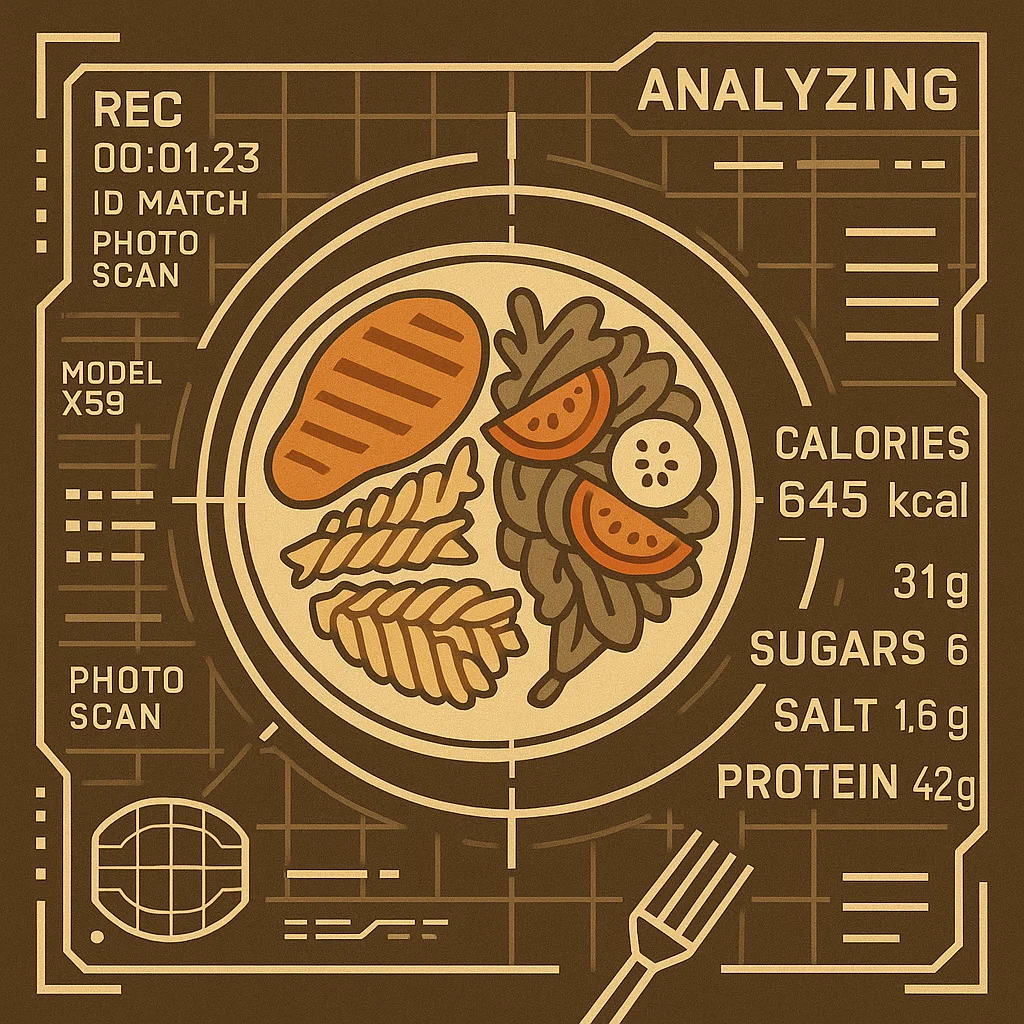

Wie multimodale KI dein Essen „sieht“

Wenn du ein Foto deiner Mahlzeit machst, laufen im Hintergrund mehrere hochentwickelte Prozesse fast gleichzeitig ab:

Schritt 1: Bildanalyse

Die KI verarbeitet zunächst die Rohdaten deines Fotos, erkennt Formen, Farben, Texturen und räumliche Beziehungen. So kann sie verschiedene Lebensmittel auf dem Teller unterscheiden.

Schritt 2: Objekterkennung

Das Modell segmentiert das Bild in Bereiche und identifiziert einzelne Lebensmittel – selbst wenn sie sich überlappen oder teilweise verdeckt sind. Es erkennt den Unterschied zwischen Burrito, Wrap und Enchilada.

Schritt 3: Detailerkennung

Die KI erkennt feine visuelle Hinweise, die Menschen oft entgehen – etwa das Bräunungsmuster auf Brot (Vollkorn?), die Textur von Fleisch (wie zubereitet?) oder den Glanz auf Gemüse (Ölanteil?).

Schritt 4: Portionsschätzung

Mithilfe räumlicher Analyse und Referenzpunkten schätzt die KI Volumen und Gewicht der einzelnen Komponenten. Moderne Systeme berücksichtigen Perspektive und Tiefe für erstaunlich genaue Ergebnisse.

Schritt 5: Nährwertabgleich

Die erkannten Lebensmittel werden mit umfangreichen Nährwertdatenbanken abgeglichen, um Kalorien, Makro- und Mikronährstoffe anhand der geschätzten Portionen zu bestimmen.

Schritt 6: Kontextuelles Schlussfolgern

Abschließend nutzt das Modell sein Wissen über Zubereitungsarten, Länderküchen und typische Kombinationen, um fehlende Informationen zu ergänzen und die Schätzung zu verfeinern.

Die Stärke unscharfer Schlussfolgerungen

Was moderne KI-Lebensmittelerkennung wirklich auszeichnet, ist ihre Fähigkeit, mit Unsicherheiten umzugehen – Ingenieure sprechen von „fuzzy reasoning“. Im Gegensatz zu klassischer Software mit starren Regeln können große Sprachmodelle:

- Fundierte Schätzungen bei unvollständigen Informationen abgeben

- Visuelle Hinweise mit deinen Texteingaben kombinieren

- Kontextwissen über typische Zutaten und Gerichte einfließen lassen

- Vertrauenswerte je nach Bildqualität anpassen

- Durch Nutzerfeedback kontinuierlich besser werden

Diese unscharfe Logik ähnelt der Arbeitsweise menschlicher Experten. Ein Ernährungsberater muss deine Pasta nicht chemisch analysieren, um zu wissen, dass sie Kohlenhydrate enthält – und kann Portionen auch ohne Waage einschätzen. KI hat inzwischen ein ähnliches Kontextverständnis erreicht.

Traditionelle Computer Vision (Früher)

- Erkannte nur spezifisch trainierte Lebensmittel

- Hatte Probleme mit gemischten oder komplexen Gerichten

- Benötigte ideales Licht und perfekte Perspektive

- Kein Kontextverständnis

- Binäre „richtig oder falsch“-Erkennung

Multimodale LLMs (Heute)

- Erkennt nahezu jedes Gericht aus jeder Küche

- Kommt mit komplexen, mehrteiligen Mahlzeiten zurecht

- Funktioniert bei verschiedensten Lichtverhältnissen

- Versteht Kontext und Zubereitung

- Arbeitet mit Wahrscheinlichkeiten statt starren Regeln

Wenn Text auf Bild trifft: Der multimodale Vorteil

Der eigentliche Durchbruch in der Lebensmittelerkennung kam, als KI-Modelle lernten, Bilder und Text gemeinsam zu verarbeiten – das sogenannte multimodale Lernen. Dadurch kann die KI Essen auf eine Weise verstehen, die vorher unmöglich war.

Machst du zum Beispiel ein Foto von einer Suppe und schreibst dazu „hausgemachte Hühnernudelsuppe“, sieht die KI nicht nur Flüssigkeit mit Einlagen – sie versteht, dass du Hühnernudelsuppe isst, und kann ihr Wissen über typische Zutaten und Nährwerte anwenden, selbst wenn nicht alles auf dem Bild klar erkennbar ist.

Diese Text-Bild-Integration erzeugt eine „Schleife komplementärer Information“: Die visuellen Daten helfen, den Text zu interpretieren, und umgekehrt. Das Ergebnis ist ein System, das deutlich präziser und hilfreicher ist als reine Bildanalyse.

„Die leistungsfähigsten KI-Systeme sehen nicht nur, was da ist – sie verstehen, was sie im Kontext betrachten.“

Herausforderungen und Grenzen

Trotz aller Fortschritte gibt es noch einige Einschränkungen bei der KI-Lebensmittelerkennung:

Diese Grenzen zeigen: KI-Lebensmittelerkennung ist ein intelligenter Assistent – kein unfehlbarer Schiedsrichter. Die besten Systeme lassen Unsicherheiten zu und ermöglichen Nutzern, Angaben zu korrigieren.

Genauigkeit und Alltagstauglichkeit im Gleichgewicht

Die größte Herausforderung ist nicht perfekte Genauigkeit, sondern das richtige Gleichgewicht zwischen Präzision und Alltagstauglichkeit. Wie wir in unserem Artikel über Einfachheit beim Kalorienzählen beschrieben haben: Ein System, das zwar 99% genau ist, aber zu umständlich für den Alltag, bringt weniger als eines, das 90% genau ist, aber sich mühelos in den Alltag integrieren lässt.

Moderne KI-Lösungen setzen daher bewusst auf:

- Tempo statt Detailversessenheit – Ergebnisse in Sekunden statt Minuten

- Intuitive Bedienung statt technischer Präzision – Einfaches Foto statt komplizierter Fragebögen

- Regelmäßigkeit statt gelegentlicher Perfektion – Lieber täglich tracken als selten, aber perfekt

Denn am Ende gilt: Der beste Ernährungstracker ist der, den du wirklich jeden Tag nutzt.

Die Zukunft der KI-Lebensmittelerkennung

Was erwartet uns als Nächstes? Mehrere spannende Entwicklungen stehen bevor:

Personalisierte Nährwertmodelle

Künftige KI wird deinen Stoffwechsel individuell kennenlernen und Nährwertschätzungen anpassen – etwa durch kontinuierliche Glukosemessung oder andere Biomarker.

Fortschrittliche 3D-Portionsschätzung

Neue Computer-Vision-Techniken werden mit Tiefensensoren oder mehreren Blickwinkeln 3D-Modelle deines Essens erstellen – für noch genauere Portionsgrößen, ganz ohne Spezialhardware.

Nährwert-Rückblick

KI wird anhand von Stoffwechselmarkern auch im Nachhinein erkennen, was du gegessen hast – etwa durch Fotos, die Stunden später aufgenommen wurden. So kannst du auch vergessene Mahlzeiten nachträglich erfassen.

Augmented-Reality-Integration

AR-Brillen werden dir in Echtzeit Nährwertinfos anzeigen, während du auf dein Essen schaust – ganz ohne Foto und mit direkter Entscheidungshilfe vor dem ersten Bissen.

Der Mensch bleibt unersetzlich

Trotz aller Technik bleibt der Mensch das wichtigste Element beim Ernährungstracking. KI ist ein intelligenter Helfer, der Hürden abbaut und Orientierung gibt – aber kein Ersatz für gesunden Menschenverstand.

Die besten Systeme der Zukunft werden modernste KI mit menschlicher Erfahrung und Intuition verbinden. Sie erkennen, wann präzise Schätzungen sinnvoll sind – und wann ungefähre Angaben für den Alltag besser passen. Sie wissen: Perfektes Tracking, das Stress verursacht, ist schlechter als unperfektes, das zu einem entspannten Umgang mit Essen beiträgt.

Am Ende ist der größte Beitrag der KI nicht die Genauigkeit, sondern die Zugänglichkeit: Indem das Erfassen von Mahlzeiten so einfach wird, dass es jeder durchhält, demokratisiert diese Technologie das Ernährungsbewusstsein und hilft Millionen Menschen, ein gesünderes Verhältnis zu Essen zu entwickeln.

Teste KI-gestütztes Ernährungstracking selbst! Mach ein Foto deiner nächsten Mahlzeit und erlebe, wie präzise Crumpeat sie analysiert – ganz ohne Messbecher oder Küchenwaage.

Mehr über die Bedeutung von Einfachheit erfährst du in unserem Artikel darüber, warum die meisten Kalorienzähler-Apps an unnötiger Komplexität scheitern.